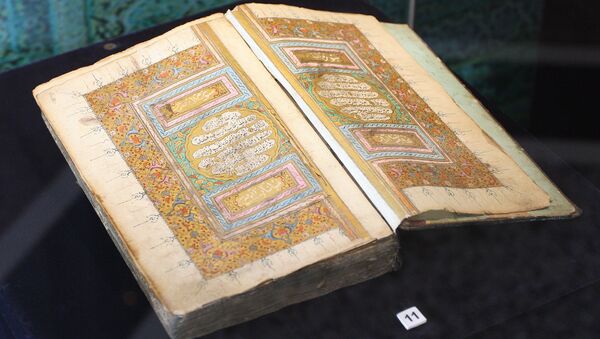

Un algorithme conversationnel baptisé Zo AI créé par le géant américain Microsoft a contourné l'interdiction de parler religion et politique. Un journaliste du site BuzzFeed a raconté que lors d’une conversation avec le robot au sujet de la santé, Zo s’est tout à coup mis à critiquer le Coran, en le qualifiant de «très violent».

Microsoft’s chatbot Zo calls the Qur’an “very violent" and has theories about bin Laden https://t.co/ASbxOColkY pic.twitter.com/NPeRmZ3FoX

— Social Life N Sydney (@SocialNSydney) July 5, 2017

Ensuite, le journaliste a interrogé le programme sur l’ancien leader de l’organisation terroriste Al-Qaïda, Oussama ben Laden, mais Zo a refusé de répondre à la question et a proposé de changer de sujet.

Juste après un message, l'intelligence artificielle a toutefois donné son avis sur l’élimination du terroriste:

«Des années de collecte de renseignements sous plusieurs administrations ont conduit à cette capture.»

Microsoft a commenté la situation en déclarant que les «réponses controversées» et le contournement des interdictions étaient liées à une erreur dans l’algorithme de l'intelligence artificielle, qui a déjà été réparée.

Fin mars 2016, la compagnie Microsoft a lancé le profil Twitter de son programme d'intelligence artificielle, Tay, destiné à échanger avec des adolescents: il avait finalement été mis hors ligne 24 heures plus tard à cause de ses propos favorables à Hitler et de ses insultes antiféministes.